下载与安装Spark

打开Spark的官网 Downloads | Apache Spark择合适自己版本的Spark安装包,下载完直接双击压缩包就会解压(建议安装一个解压软件),将其重命名为spark放到/usr/local/Cellar下面。

打开.bash_profile文件,添加:

export SPARK_HOME=/usr/local/spark

export PATH=$PATH:$SPARK_HOME/bin

# Configure Spark to use Hadoop classpath

export SPARK_DIST_CLASSPATH=$(hadoop classpath)利用以下命令更新环境变量:

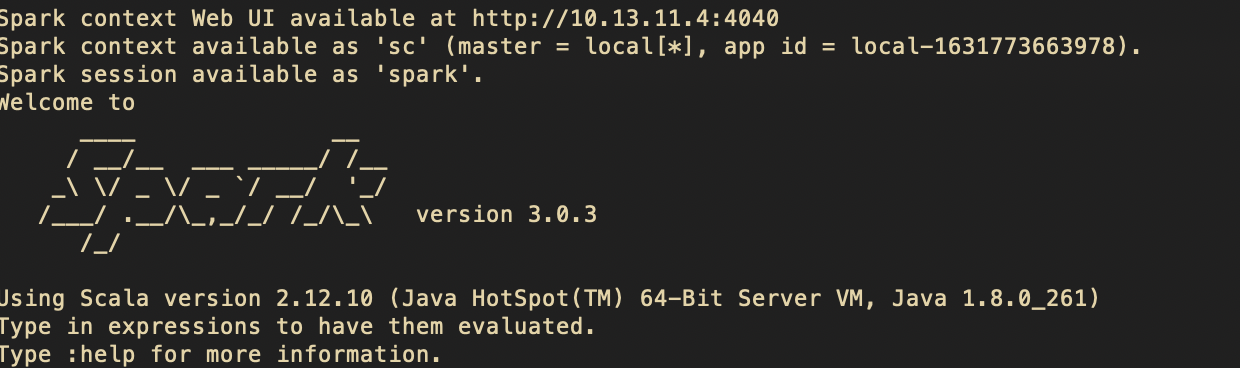

source ~/.bash_profile安装完毕,在终端输入:spark-shell,如果出现了下面的情况,代表安装成功了。

本博客所有文章除特别声明外,均采用 CC BY-SA 3.0协议 。转载请注明出处!