解决Spark运行期间LOG输出INFO过多

运行spark-sql或者spark-shell的时候经常会出现满屏的INFO输出,影响对结果的阅读。

这个时候只需要在spark-conf/conf/下设置好log4j.properties文件中的log4j.rootCategory就可以解决,甚至进行深度研究后可以自由设置应该展示哪个部分的信息。

复制log4j.properties.template为log4j.properties

cp log4j.properties.template log4j.properties

vim log4j.properties原文件设置:

log4j.rootCategory=INFO, console改为:

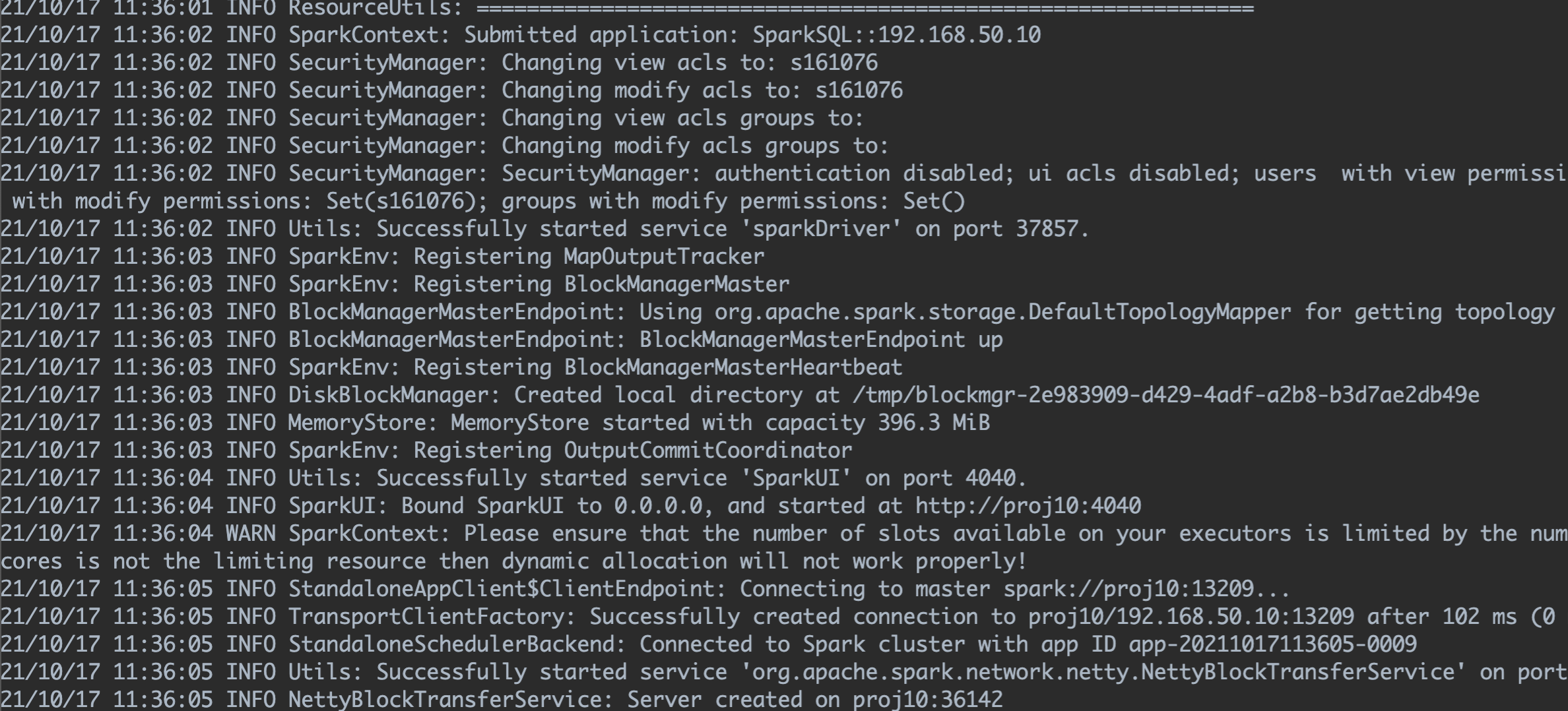

log4j.rootCategory=WARN, console效果:

Spark/Hive运行.sql文件

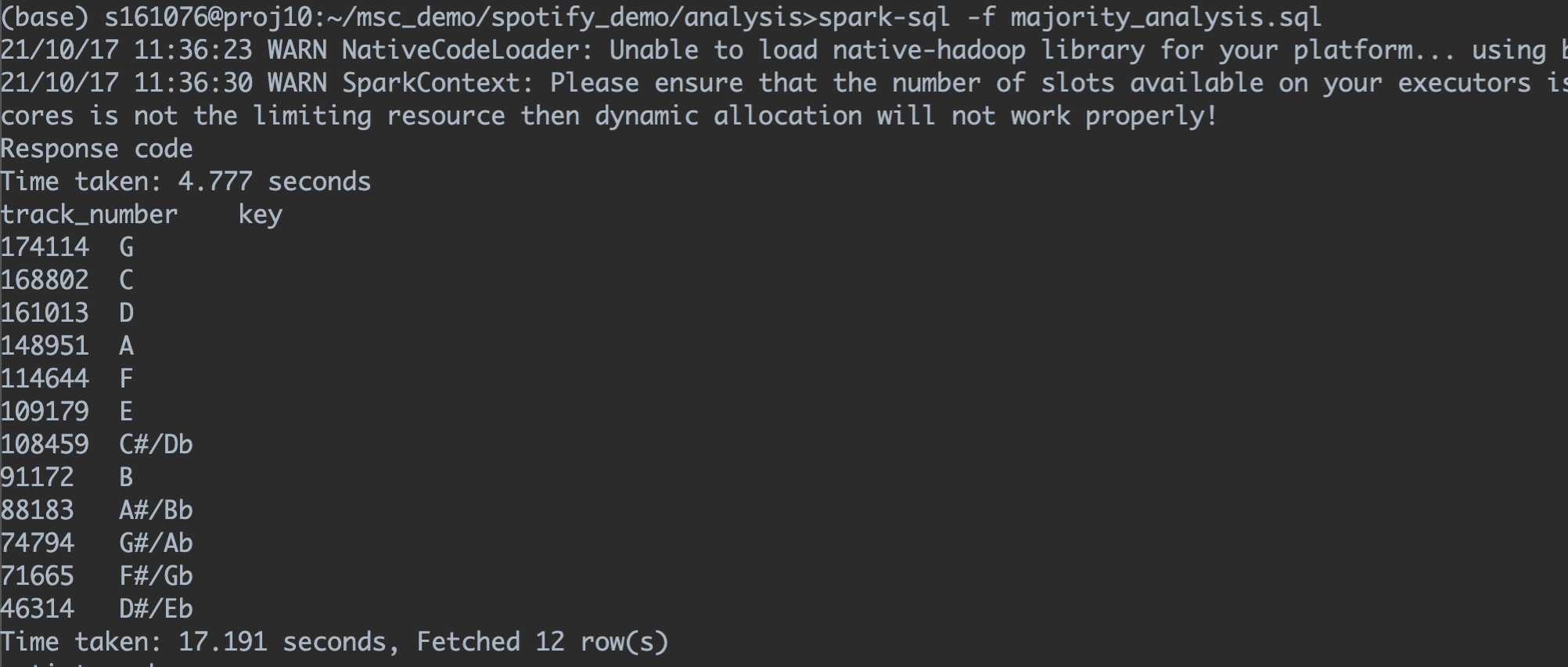

Spark运行.sql

spark运行.sql文件的组件为 spark-sql,使用方法:

spark-sql -f example.sqlHive运行.sql

hive运行.sql文件的方法有两种。

Hive直接执行

hive -f example.sqlhive shell执行

进入hive shell之后使用source命令执行

hive

>>进入hive shell了

source example.sql本博客所有文章除特别声明外,均采用 CC BY-SA 3.0协议 。转载请注明出处!